반응형

- LocalAI

- 인터넷 없이 Local에서 AI 활용 가능

- 다양한 모델들도 쉽게 다운로드 하여 활용 가능

- GPU 필요하지 않음

- 공식 사이트

GitHub - mudler/LocalAI: :robot: The free, Open Source alternative to OpenAI, Claude and others. Self-hosted and local-first. Dr

:robot: The free, Open Source alternative to OpenAI, Claude and others. Self-hosted and local-first. Drop-in replacement for OpenAI, running on consumer-grade hardware. No GPU required. Runs gguf,...

github.com

- LocalAI 설치

- 설치 스크립트로도 설치가 가능

- 도커 컨테이너 형태로도 배포 가능

- 도커 컨테이너 형태로 설치

- CPU, GPU 각 환경에 맞춰서 설치 진행

- GPU가 없는 관계로 CPU Only Image로 진행

# CPU only image:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-cpu

# Nvidia GPU:

docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia-cuda-12

# CPU and GPU image (bigger size):

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest

# AIO images (it will pre-download a set of models ready for use, see https://localai.io/basics/container/)

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu

- CPU Only Image

- 용량이 다수 큰 존재로 설치 시간이 소요됨

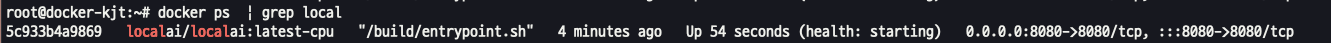

docker run -d --name local-ai -p 8080:8080 localai/localai:latest-cpu

- 접속

- 접속하면 기본적으로 모델들이 존재하지 않음

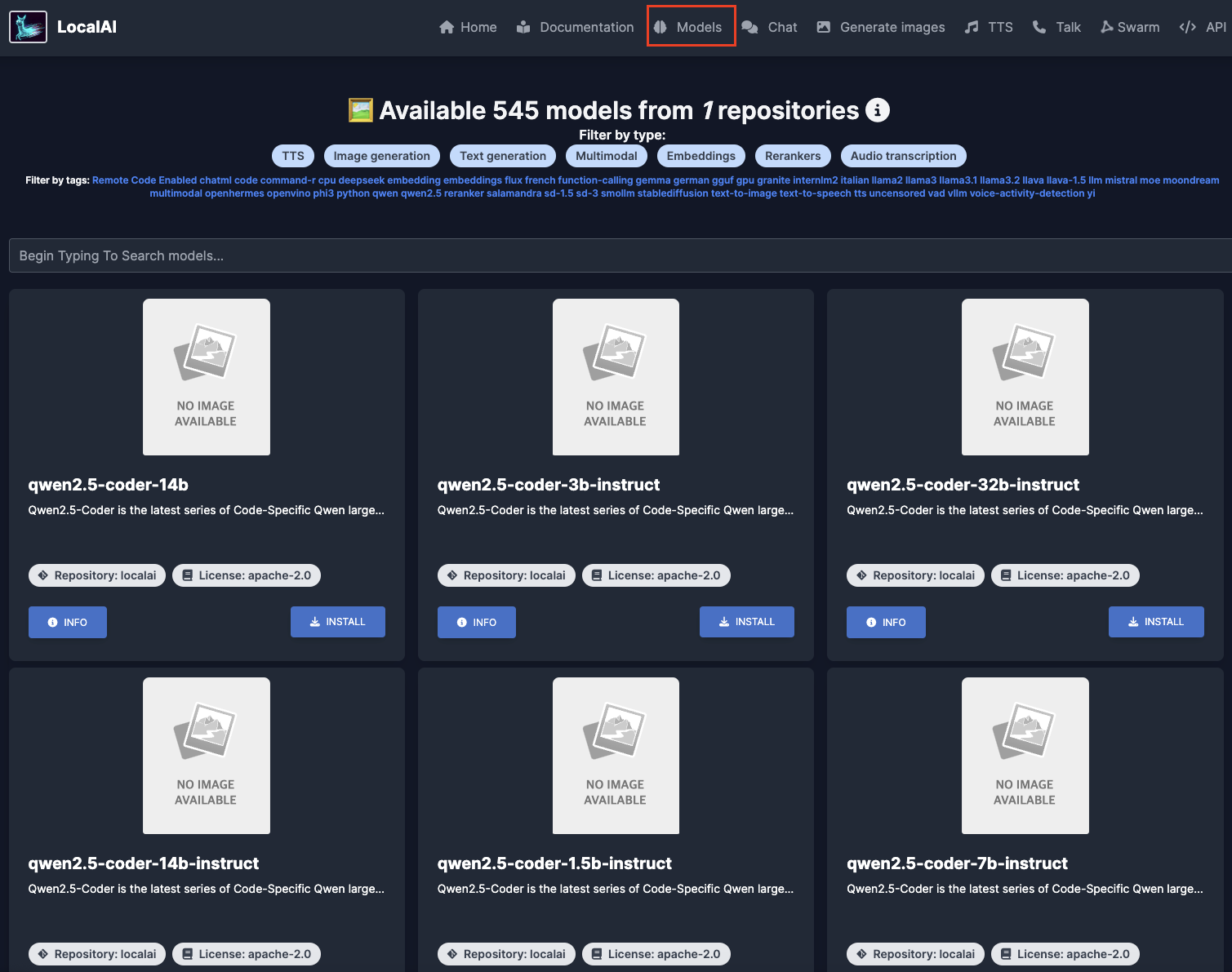

- 원하는 모델 설치하기

- 상단 메뉴 -> Models 선택

- 원하는 모델들 다운로드 받을 수 있음

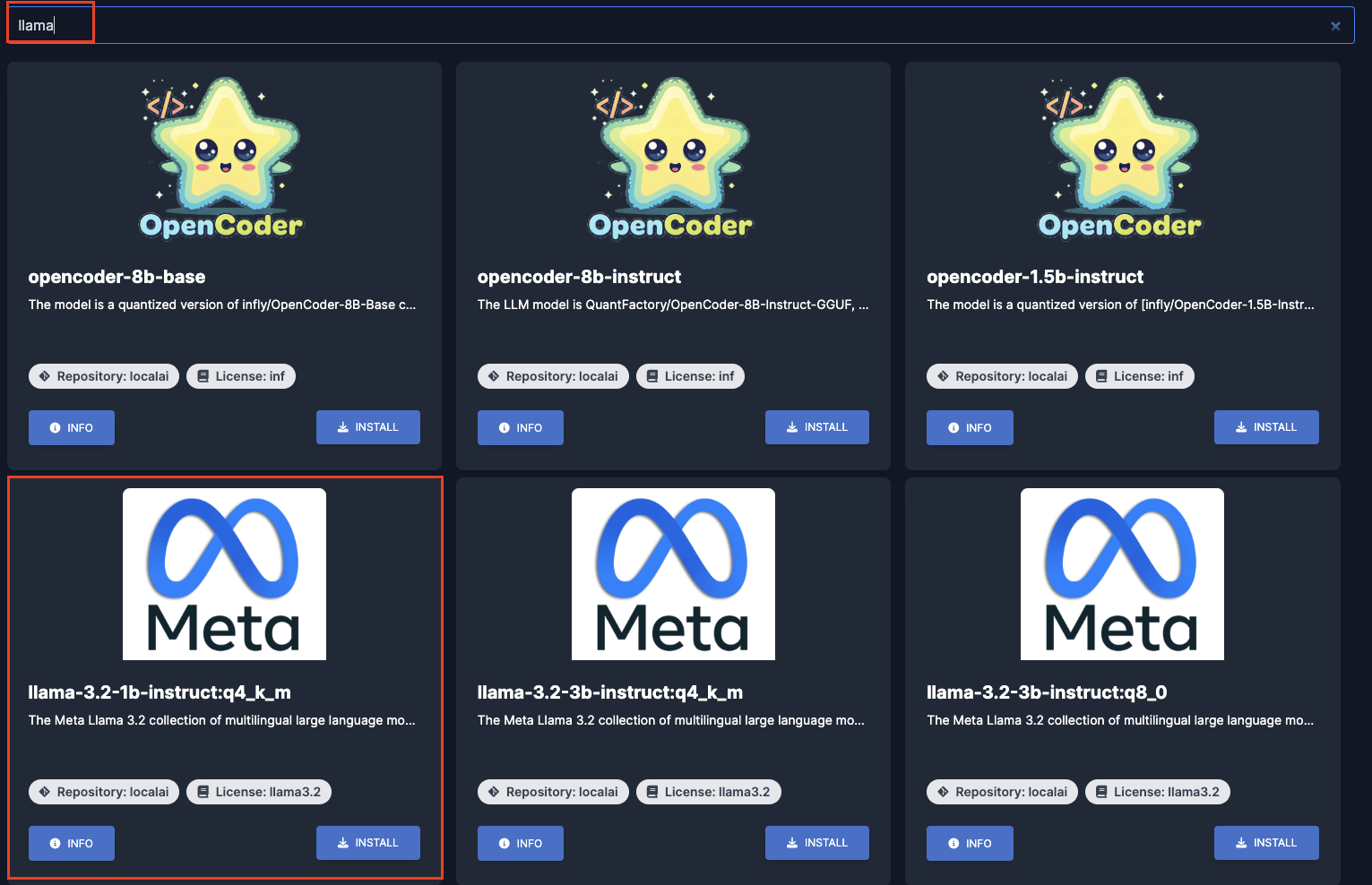

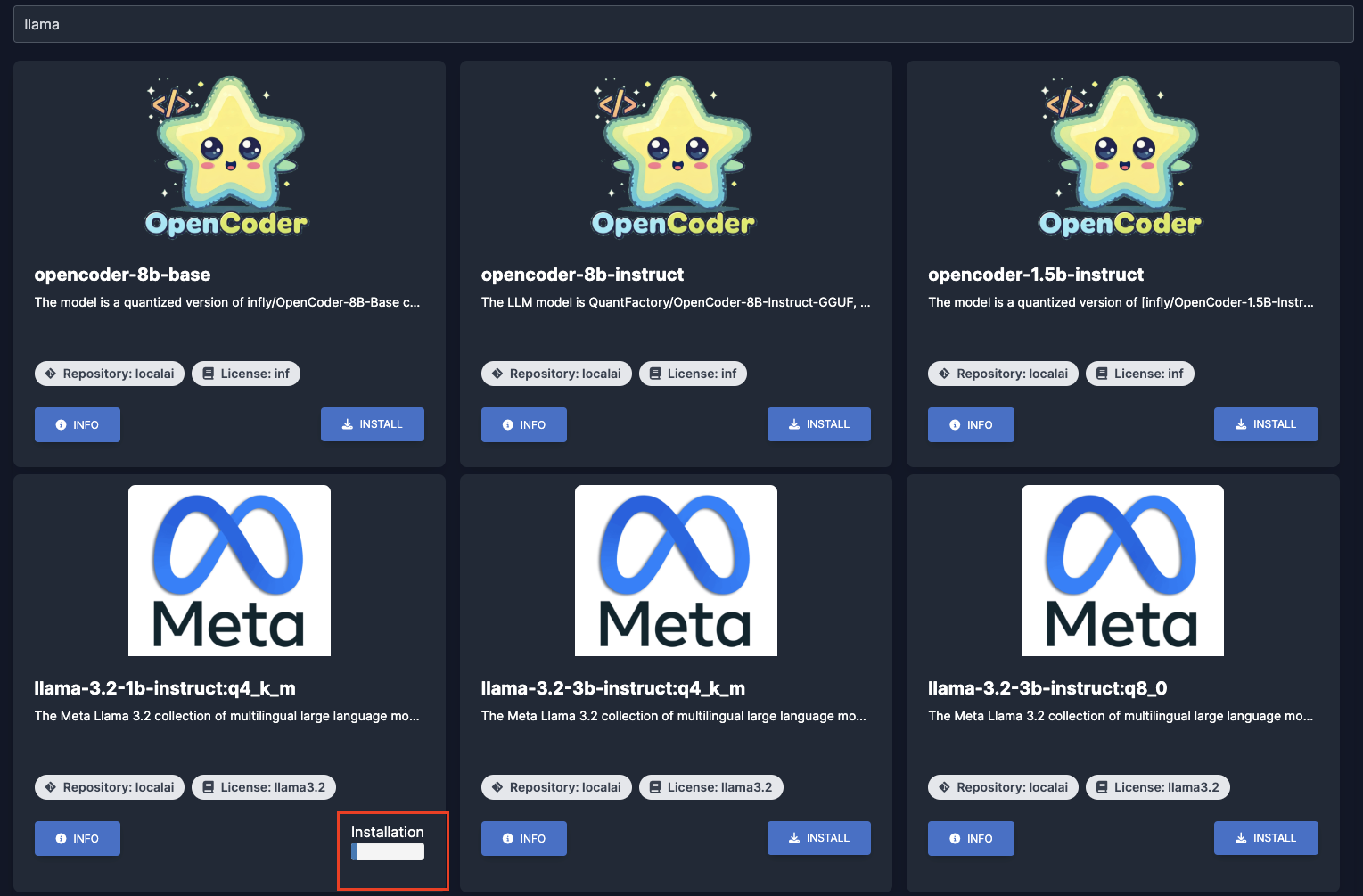

- 모델 다운로드

- 원하는 모델 이름 검색하고 -> 해당 모델 -> INSTALL 클릭

- 설치된 모델 확인

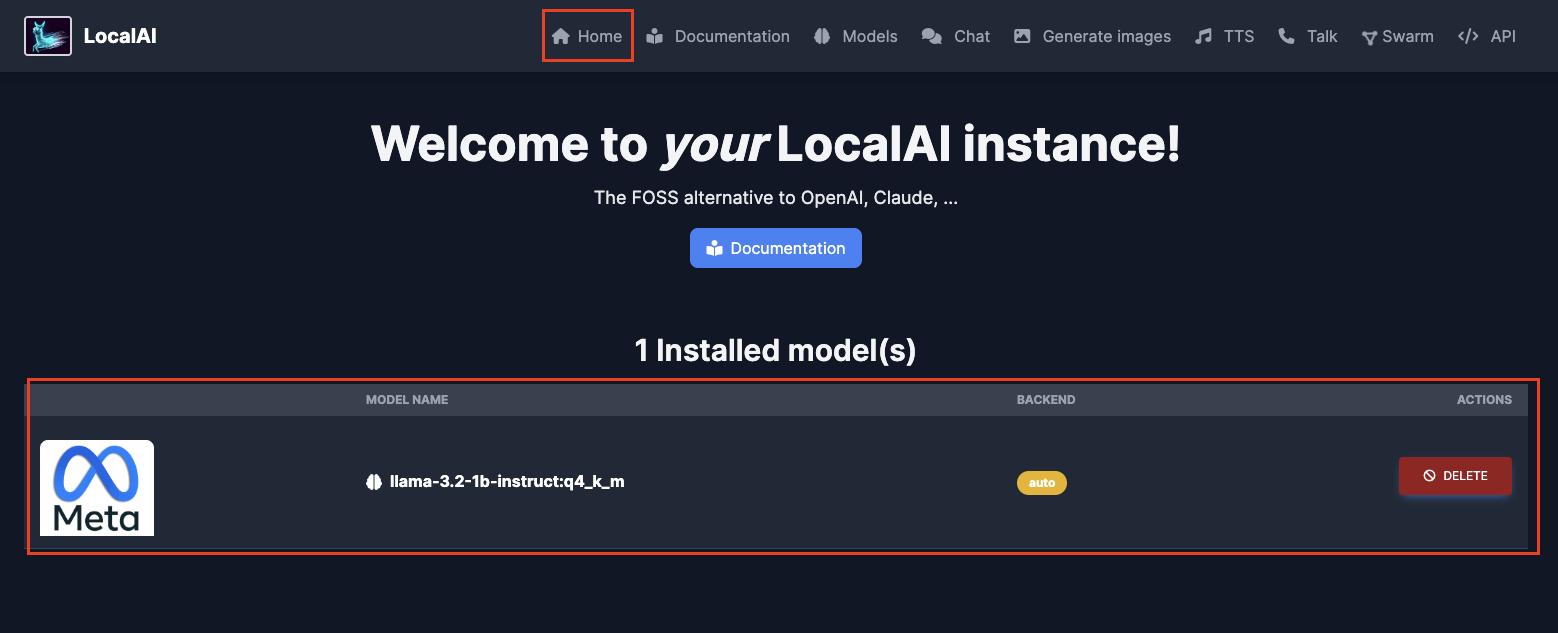

- 상단 -> Home -> 다운로드 된 모델 정보 확인

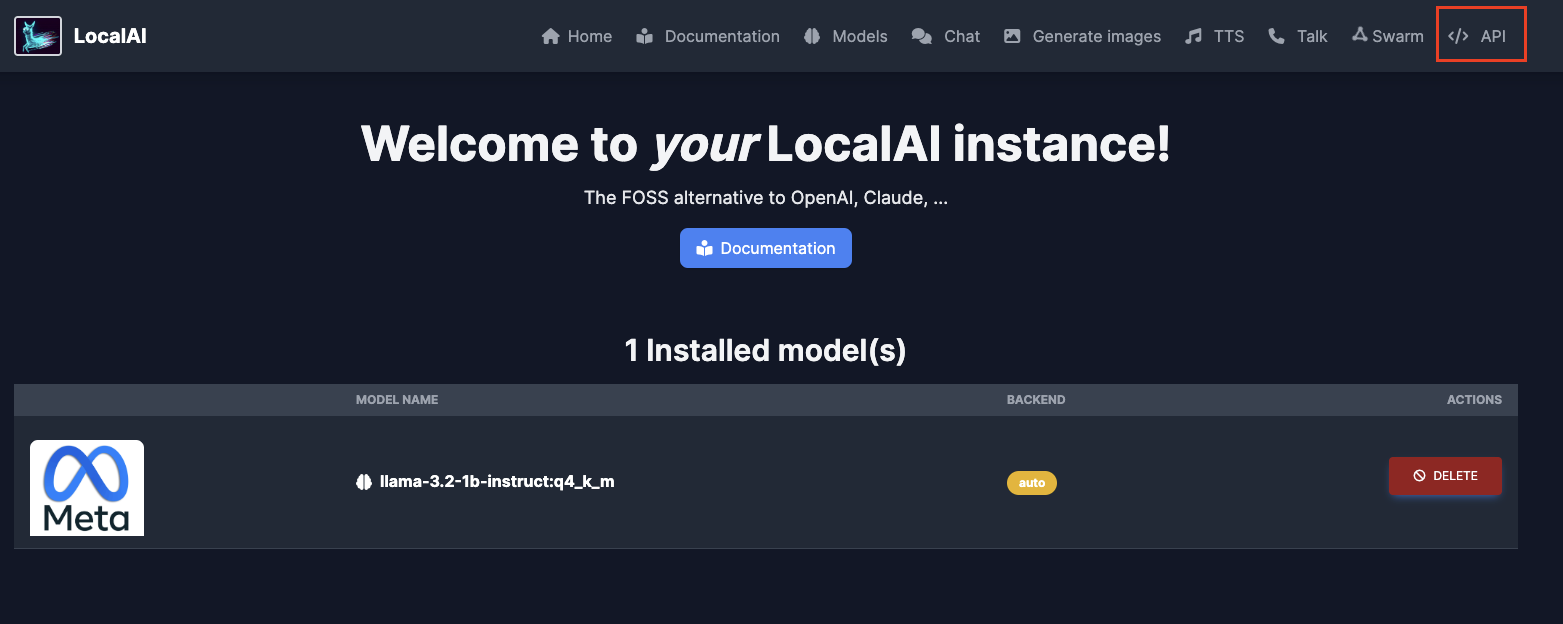

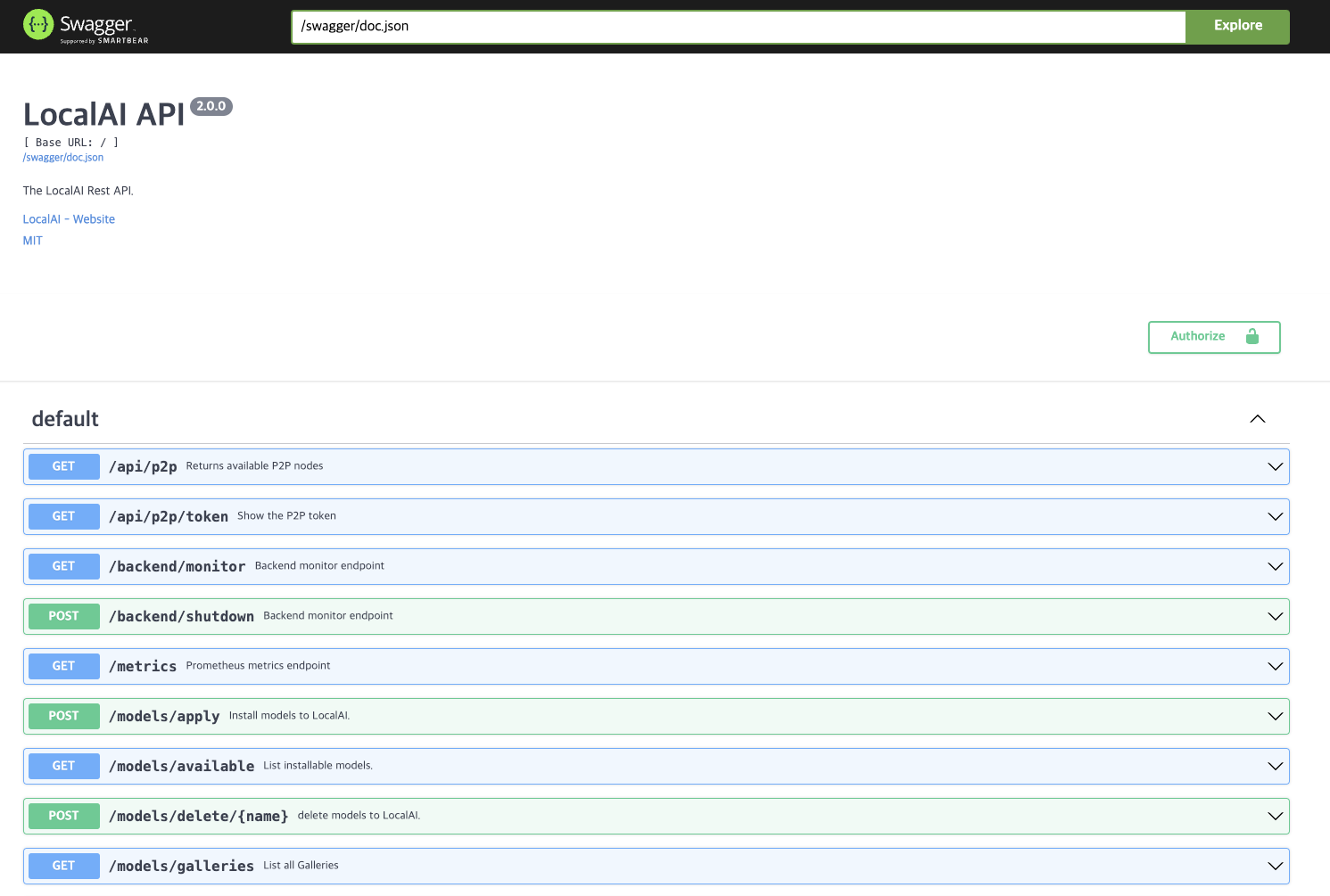

- RestAPI 를 제공

- http://"IP"/swagger 접속

- 상단 -> API 클릭

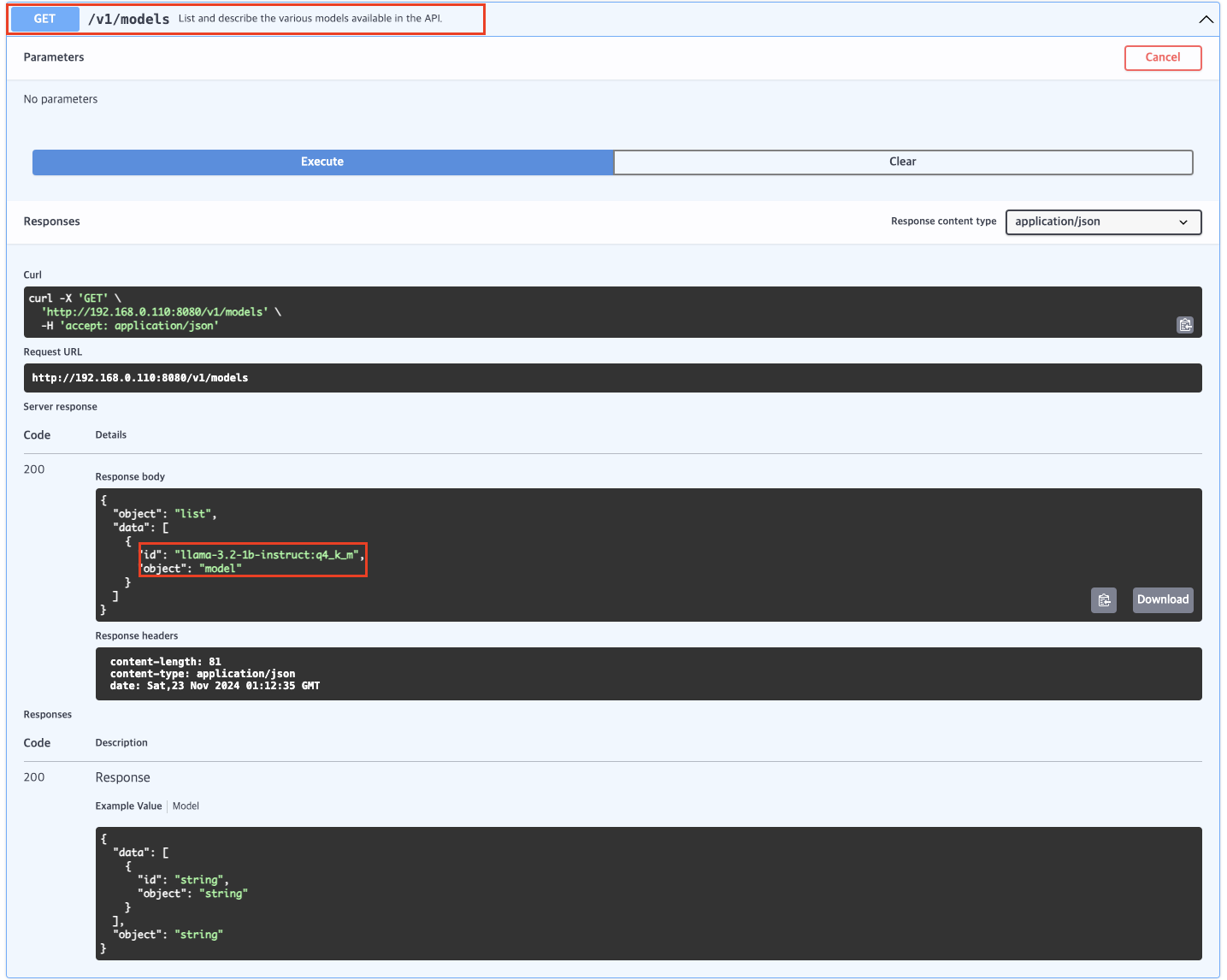

- RESTAPI를 통한 모델 정보 확인

반응형

'기타' 카테고리의 다른 글

| K8SGPT 구성하기 (0) | 2024.11.23 |

|---|---|

| [zabbix] zabbix Agent 설치 (2) | 2024.11.14 |

| [zabbix] zabbix Server 설치 (1) | 2024.11.14 |

| NFS 서버,클라이언트 설치 및 설정 (1) | 2024.07.25 |

| Rancher 활용하여 kubernetes Cluster 구성하기 (0) | 2024.04.24 |

댓글